The Ugly Truth… : « Ce gros mois de m.AI »

Cette Newsletter t'accueille dans le monde de demain. J'y parle d'innovation, d'IA, de transformation, de leadership, de grandes idées, de cassoulet, de startups et de toi.

🔊 EDITO BY NASH

🤡 “Champions League? Nah ! AI dude! Always AI!”

🎁 QUI VEUT DES PERKS ?

👑 Ce mois-ci : “qui veut des events ?” parce que IA récré !

🏜 WHISPER OF THE VALLEY

👽 Ben Evans 2025

⚡ Google’s game

🦋 Mistral et les agents

🐇 Du côté de chez Sam (Altman)

🥸 MCP et petites histoires

💋 Les pirates sont là !

🦁 Tesla et les robotaxis

👀 Meta Quest : un autre niveau

👠 Elon et les 1000 fusées

🍔 FOOD FOR THOUGHT

🙈 Quand Figma réinvente la mesure de l’IA

🪴 IMPACT

🧶 Bad Impact : Science-fiction = steak

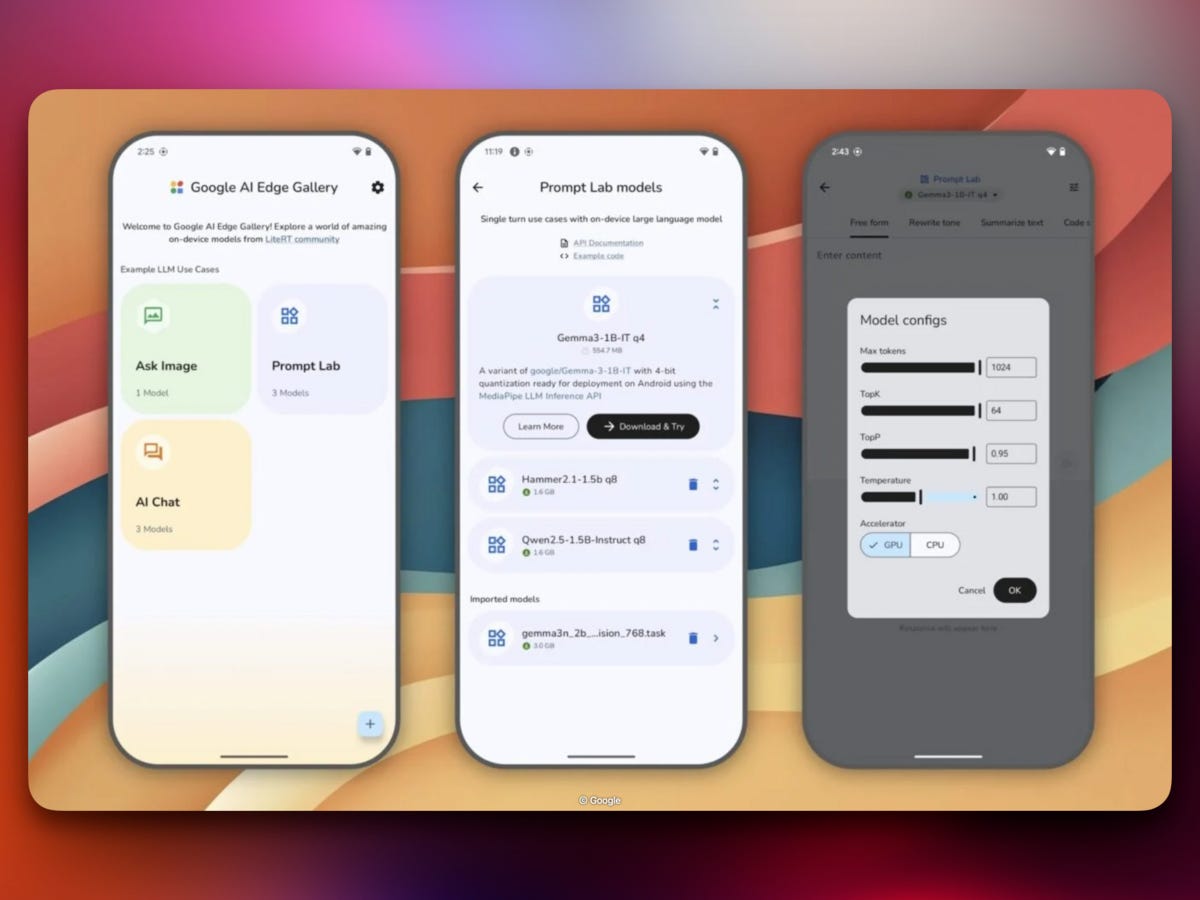

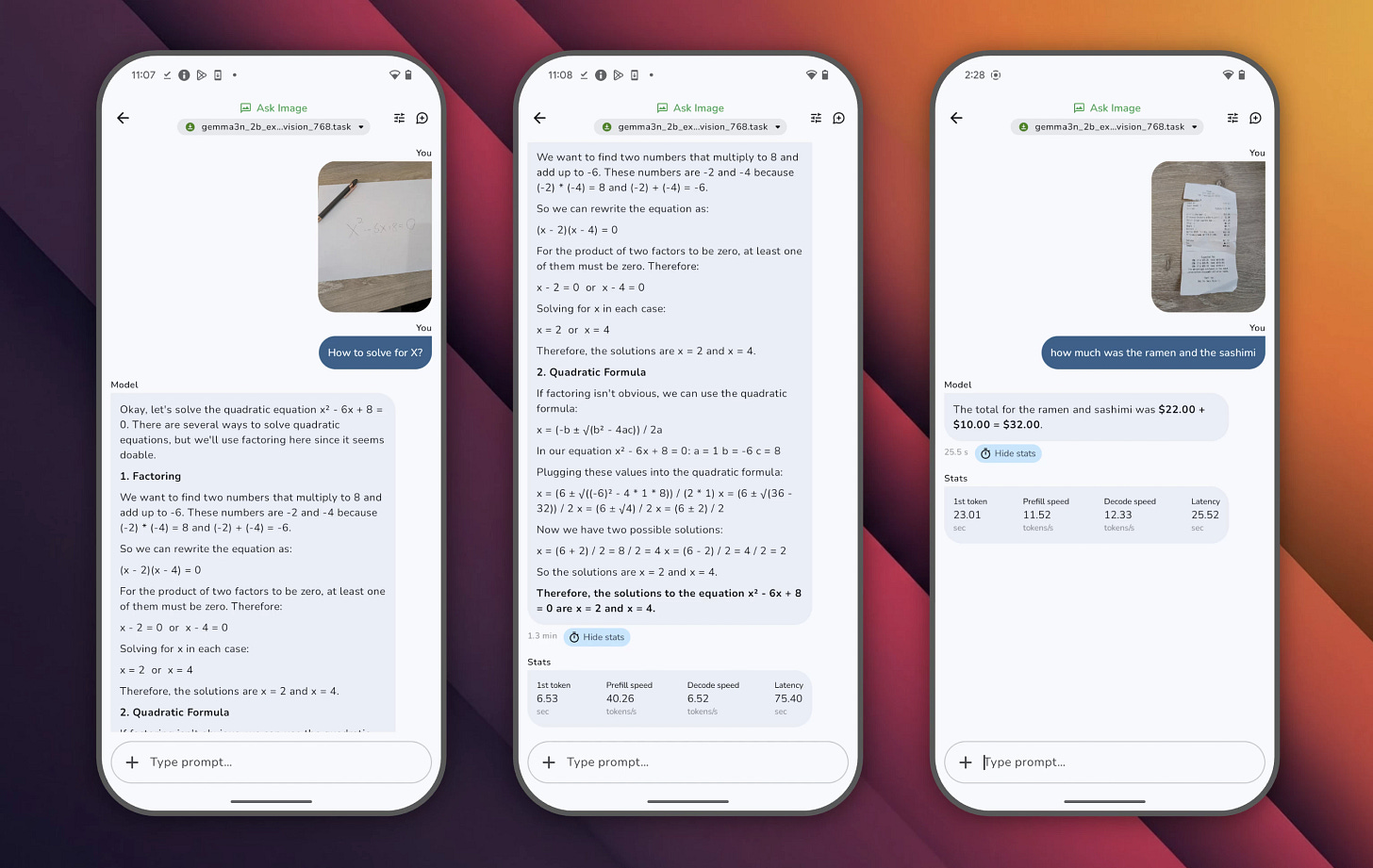

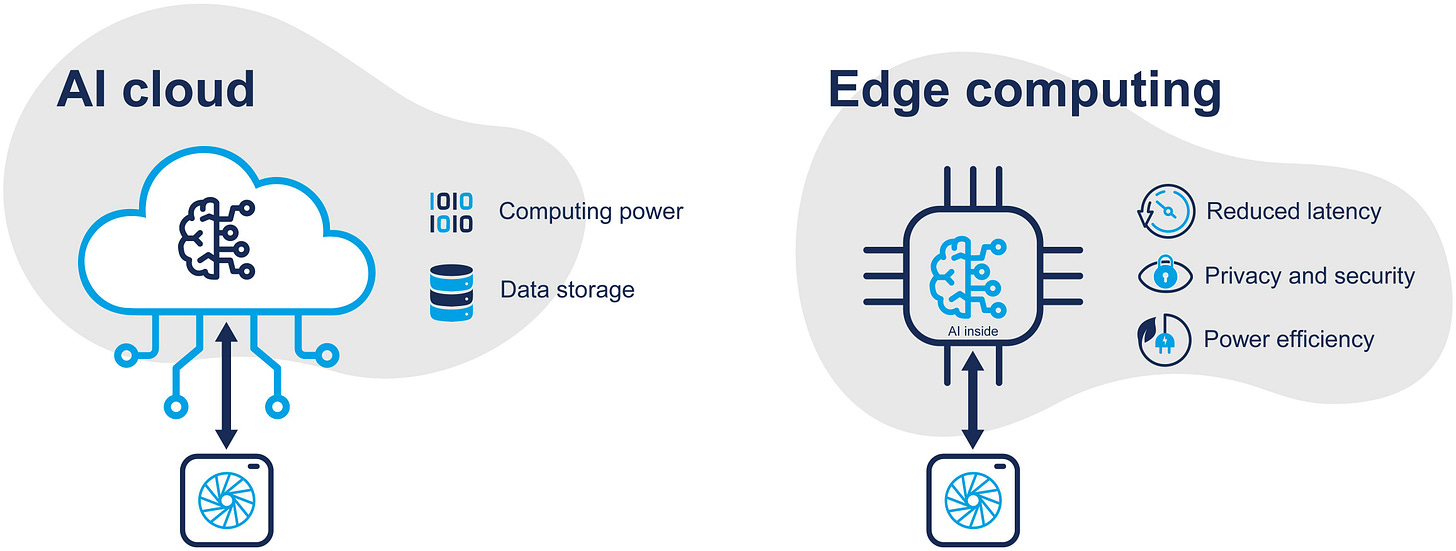

🐇 Good impact : une IA qui tourne en local !

🌐 FRIENDS AND NETWORK

🧚🏻 Habs.ai : ton cerveau est la clef !

🔞 AND NOW FOR SOMETHING COMPLETELY DIFFERENT

😂 Are you a robot?

🦄 Y’A PAS QUE LA TECH !

🎼 Vivatech, c’est pas d’la tech !

Edito by Nash :

Tu m’excuseras pour ces 3 semaines d’absence : mais avec une annonce toutes les deux heures en moyenne depuis plusieurs jours, je n’ai jamais vraiment trouvé le « bon moment » pour sortir ma newsletter… donc tu vas à nouveau bouffer du Kling, du OpenAI et du Google : je te prie de bien vouloir m’excuser !

Et bravo à Paris qui n’est pas mon équipe de coeur (suis lyonnais !), parce que c’était bien quand même. Et pas bravo aux cons qui cassent tout même quand ils gagnent !

……

Allez, on y va !

L’autre matin, j’écoutais attentivement Elise Bordet, jeune (et jolie) chercheuse, très en colère sur BFM Business.

Parce que oui, le matin, pour bien commencer la journée, je regarde ou j’écoute BFM Business où des gens râlent ou gueulent selon les jours, les décisions de Trump ou les reculades de Bayrou.

En tout cas, ils gueulent !

Et d’habitude, ça me fait marrer, réfléchir deux minutes, voire ça me saoule, mais là, clairement, chez Elise Bordet, la colère semblait légitime et était bien expliquée.

La jeune chercheuse exposait simplement la double peine que vit actuellement la recherche fondamentale française : pas de moyens, des carrières pas financièrement attractives, pas de revalorisation en vue, et le tout, pendant que les pouvoirs politiques font les yeux doux et sortent le carnet de chèque aux chercheurs étranger, notamment US, pour surfer sur la vague que vient de déclencher Donald Trump qui estime que les chercheurs ne servent à rien, que les académiques sont nazes et que les universitaires devraient tous mourir la tête au bout d’une pique, laissant nos politiques européens penser qu’ils vont rafler la mise et chopper du prix Nobel à la pelle !

J’exagère, mais c’est pour ça que tu m’aimes !

Alors autant je suis de ceux qui aiment que l’on joue les opportunistes face à des clowns comme Trump pour tenter de ramasser quelques miettes de sa piñata de 4h, autant je n’ai jamais compris que l’on ne casse pas notre tirelire en France pour l’enseignement supérieur et la recherche, parents pauvres de l’éducation nationale (le plus souvent) ou secrétariat d’état triste rattaché à l’industrie (parfois) !

Comme tu le sais, pour moi, la première et plus importante dépense économique de notre pays doit être l’Education. Sans aucune discussion possible. (Et juste avant le logement !)

Alors à ma façon un peu libérale de voir les choses, évidemment ! C’est-à-dire en dégraissant massivement le mammouth : 75% de gens en moins dans les rectorats et aux postes administratifs et 75% de salaire en plus pour les enseignants ! A peu de choses près.

Mais je m’égare ! Et pas que Montparnasse (comme le disait encore si bien Desproges !)

Pour en revenir à la recherche, ce que j’ai aimé dans ce que Elise Bordet expliquait c’est son histoire personnelle, le fait qu’elle parlait d’expérience et qu’elle n’était pas là pour donner des leçons depuis un lointain rivage militant ou théorique, non !

Son rêve à elle, a réellement été détruit par cet état des choses : elle a en effet dû abandonner son envie de petite fille de faire de la recherche fondamentale ! Elle avait ensuite côtoyé un semi-bonheur dans le privé, mais ne s’était jamais vraiment retrouvée là où elle pensait devoir être : à la recherche fondamentale… là où tout commence.

Là aussi où, comme elle le rappelait si bien, les gens « qui n’y connaissent rien » disent bien fort dans les diners en ville, que « la recherche fondamentale, ça doit être rentable ! »

LOL

Ineptie à qui sait de quoi il s’agit, mais que l’on entend malheureusement jusque dans la bouche de certains politiques qui ne distinguent que mal les vessies parmi les lanternes.

Non, la recherche fondamentale n’est pas de la recherche appliquée. Non, la recherche fondamentale n’est pas le coin poussiéreux et inutile de la science : c’est le terreau de toutes les découvertes, de toutes les avancées et de tous les progrès.

Et ça coûte cher !

Et nous sommes forts en recherche fondamentale, en France.

Faisant depuis si longtemps avec mauvaise fortune bon cœur ! Laissant partir nos plus beaux cerveaux vers les eldorados d’outre-Atlantique…

Mais tout ça c’est fini, puisque Trump a déclaré la science aussi utile qu’une porte sans poignée, n’est-ce pas ?

Alors on comprend pourquoi, lorsque notre président et quelques autres, promettent des salaires mirobolants (comprendre « au niveau de ceux pratiqués en recherche fondamentale aux US ») aux potentiels arrivants américains, celles et ceux qui galèrent à trouver 3 euros pour racheter un lot de pipettes pour le labo crient au scandale !

Sans compter que l’on pourrait commencer par récupérer nos cerveaux évadés plutôt que de commencer à vouloir importer ceux des autres !

Je ne suis pas chercheur.

Je ne suis pas même politique (pour l’instant) !

Mais à l’heure où la France s’apprête pour 2026 à passer sous les serpes les plus aiguisées des gendarmes du ministère des finances pour réparer un budget qui crisse, qui pète, qui craque et qui déborde de toute part, il est légitime de fixer quelques garde-fous : et l’enseignement et la recherche ne devraient pas, une fois encore, faire les frais de la mauvaise gestion des politiques.

Ce n’est que mon avis.

Et celui d’Elise Bordet.

……………………..

L’IA s’invite partout, ce n’est plus une surprise !

Avec Google I/O, c’est une percée aux heures de grandes écoutes que s’est payé l’IA générative !

Tant les performances des outils les plus tapageurs laissent sans voix, le journaliste lambda s’est emparé enfin de l’IA pour ne pas (seulement) la dénigrer, et en notant que les évolutions régulières de celle-ci devaient signifier que l’IA n’est pas « par nature », magique !

On progresse !

Je parlais à l’instant avec certains membres de la communauté de Carlos Diaz de l’importance des faits et de leur vérification (facts checking) après avoir visionné un sketch d’un humoriste dont la vanne repose sur une fake news communément admise pour « véridique » auprès du grand public.

Cette anecdotique conversation mettait cependant en avant que la presse, les media dans leur ensemble n’avait jamais traité l’IA avec objectivité et étaient les seuls coupables d’une très mauvaise image, d’une pandémie de croyances et peurs plus débiles les unes que les autres et d’une adoption ultra ralentie en entreprise et encore plus au sein des établissements publics !

Après avoir laissé passer le train des LLM (à un Mistral près), et alors que nous voyons démarrer ceux de la Chine puis des US en matière d’enseignement de l’IA, nous allons devoir faire, avec nos malheureuses petites heures de « cours en ligne » comme elles sont annoncées pour la rentrée, devoir faire, donc, avec une population totalement à la ramasse, loin de toute réalité d’usage et incapable une fois encore de distinguer une IA générative ordinaire d’une Margarine allégée 18%.

Et j’en veux aux media, oui, parce que comme pour de nombreux sujets (comme la politique, par exemple), nos amis journalistes ne se soucient plus de faire un travail de recherche réel pour aller au fond des choses, se laissant parfois séduire par le sensationnel, l’imprévu, l’extraordinaire, mais aussi la plupart du temps, par la peau de banane, la tarte à la crème, le gadin et tout ce qui choque (scandale, faute, trouble, erreur, manigance, arrangement, etc…).

Et l’IA ne vend jamais autant que lorsqu’elle fait peur !

Donc on a maintenant un nouveau sujet clivant : IA, pour ou contre !

Comme si le débat était là, et comme si l’on allait apprendre à marcher aux bébés en leur interdisant de se mettre debout ! Bref : encore une belle occasion ratée de bien faire son travail !

Mais avec Veo3, Flow et quelques autres sorties récentes, lorsque l’IA générative permet de produire une séquence vidéo plus vraie que nature, tournée-montée-truquée-bruitée-sonorisée alors là, la rédaction des JT s’est quand même fendue d’un petit tour sur internet !

Même Quotidien a filé le sujet à son « petit Q » qui traite d’ordinaire des actus People… c’est dire !

On est à deux doigts d’un retournement de situation !

Et en France on les aime, en ce moment : le nucléaire est redevenu notre copain et prochainement ce qui nous rapprochera le plus de nos amis Allemands ! La retraite par capitalisation n’est plus le gros mot qu’elle a été pendant les 40 dernières années et devient même un placement demandé par les salariés en France au point que certains syndicats « ne l’excluent plus » ! Alors de là à ce que l’on dise : « vive l’IA, Vive l’IA Française ! Vive Mistral ! » il n’y a qu’un pas !

Pour l’instant j’en suis à faire encore beaucoup de pédagogie sur la qualité de la data (pour tuer l’idée de l’IA magique) et du facteur humain (pour revenir sur toutes les croyances et peurs limitantes !), parce que le narratif de la peur a jusqu’ici bien fonctionné : les collaborateurs sont tétanisés face à des outils IA ad-hoc ou des softwares adaptés à leur boite, tandis qu’ils sont plus de 60% à utiliser un GPT en scred, chez eux ou au taf !

Ca rend schizo, en plus, cette histoire ! « J’aime pas l’IA, donc je l’utilise ! »

Il y a aussi les secteurs que l’on annonce régulièrement « morts » à cause de l’IA…. Et dont on attend toujours la date des obsèques, sans cesse repoussée…

Etonnant, non ?

On s’aperçoit aussi de la valeur de nos séniors en entreprise : ils ont la compétence pour savoir si l’IA a craché de la merde ou pas ! Alors que le petit Gaspar, fraichement sorti d’HEC n’en a pas la moindre idée ! Serait-on sur le point de voir s’inverser la tendance de l’employabilité ? Avec en ligne de mire un problème majeur de sociétés « mâtures » : le jeune sans expérience à qui l’on ne donnera jamais sa première expérience, parce qu’il sera toujours moins bon qu’une batterie d’agents IA et de 2 pré-retraités !!???

Qui sait !?

………………………

Europe – Etats-Unis : 50 nuances de taxes ! (les faits et les dates de ce qui va suivre ne sont pas vérifiés et peuvent être le fruit de mon imagination débordante !)

Le lundi, tout va bien. Petite partie de golf à Mar a Lago.

Le mardi, c’est chiant parce qu’il y avait des nuages, donc retour à Washington pour organiser le délit d’initiés autour des cryptos.

Mercredi, menace sur les 5 députés républicains qui ne veulent pas voter le budget : finalement, comme ils tiennent à leur siège, ils voteront le budget.

Le jeudi, on a voté, on peut aller au golf et essayer pour la première fois un petit jouet à 400 000 000 de dollars offert par un patelin du Golfe, justement…

Vendredi, on se fait un peu chier, donc on menace l’Europe de 50% de tariffs mis en place dès le 9 juin.

Samedi, sieste et sortie du chien et de Melania.

Dimanche : on n’aime plus les tariffs sur l’Europe, et dans la foulée, on se met même à piquer un peu Poutine « qui n’est pas gentil gentil, même si Zelensky dit des choses un peu méchantes qu’il ne devrait pas dire » (source : porte-parole majorette de la Maison-Blanche)

Résultat, c’est le printemps, et les bourses remontent, les bonus des traders se dardent, et il n’y a pas qu’eux… dit l’obsédé de la rue Tartarin ! (Desproges encore ! Je dois avoir une IA à la con dans le lobe gauche !)

Bref : si nous ne sommes pas encore morts par anéantissement mondial d’ici à la prochaine newsletter, il est temps pour moi de te recommander de te garder du mal et de prendre soin du rock n’roll !

Et si tu as des enfants (entre 8 et 13 ans), lis la suite !

« Qui veut des événements cools ? »

Ca y est, c’est l’arrivée de « IA Récré » !!! Et ça va être chanmé ! T’as maté la vidéo juste au-dessus, non ?

Le 7 juin, avec le concours de Artifex Lab, nous organisons la première session d’un rendez-vous mensuel pour initier les plus jeunes à la création boostée à l’IA. Avec un peu de bol, la suivante sera à Marseille en juillet ! (pas fou, on va au soleil, l’ami !)

A chaque rendez-vous, un artiste vient raconter son univers, et pour la première, c’est Stéphane Galienni que tu peux connaitre aussi sous le nom de Incognito Influenceur et que tu as peut-être vu lors des fashion weeks s’incruster dans les défilés des plus grands couturiers… pour de faux avec l’IA ! Non ?

L’artiste, chaque session, devra donner une direction voire un thème aux enfants et les guider pour qu’ils puissent eux-aussi, à leur tour, créer un chef d’œuvre.

Pour le 7 juin, c’est encore secret : sois patient ! Et inscris tes gosses, ça sera déjà ça de fait ! C’est ici que ça se passe : https://www.eventbrite.com/e/ia-recre-tickets-1379200659299?aff=oddtdtcreator

7 JUIN à 10h jusqu’à 13 heures (puis on mange).

Pour les enfants de 8 à 13 ans.

A Artifex Lab, 10 rue la Vaquerie, 75011, Paris (métro Voltaire)

Fort à parier que Stéphane, adepte de la photo et venant de la com, prendra comme matière première des clichés à l’ancienne… mais selon les artistes, le début de la création pourra se faire avec des outils traditionnels plus malléables : colle, photo, pâte à modeler, papier, carton, crayons, fils, et tout le toutim.

Une fois la création prototypée, les enfants iront d’ateliers en ateliers, pour donner vie, via des outils d’IA générative de création, à une œuvre achevée et boostée par l’IA.

Petit vernissage avec les parents autour d’un verre et d’une planche de machins à manger, ce samedi 7 juin à 13h, au théâtre de l’IA, avec beaucoup de bonne humeur !

Avec tout ça, tu obtiens des enfants éclairés qui se sont éclatés, des parents qui se disent que l’IA « c’est peut-être pas de la merde », et un événement qui fait boule de neige…

Tout le monde est content, quoi ! Allez : fonce, il faut 16 gamins pour que ça fonctionne !

Prochaine étape : Marseille le 5 juillet, avec Gilles Guerraz, septembre à Lyon, octobre à Bordeaux… et on verra bien la suite !

« Whisper of the Valley »

Le Ben Evans 2025 est arrivé !

Un peu de contexte : Benedict Evans, c’est le mec qui observe la tech depuis sa tour d’ivoire (enfin, surtout depuis son bureau londonien), et qui, chaque année, balance une sorte de “State of the Union” du numérique. Sa présentation 2025, c’est 120 slides de pur jus, où il raconte comment l’IA, loin de n’être qu’un buzzword, commence à vraiment bouffer le monde… mais pas du tout comme on l’imagine dans les films de Spielberg.

Il commence fort avec une question qui claque : “À quoi sert vraiment l’IA aujourd’hui ?”

Spoiler : pas à grand-chose pour le commun des mortels.

Oui, tout le monde a testé ChatGPT, Midjourney ou DALL-E, mais combien les utilisent vraiment dans leur quotidien ? Il cite un chiffre frappant : 100 millions d’utilisateurs actifs pour ChatGPT, mais un taux de rétention qui s’effondre après quelques semaines. C’est un peu comme le régime détox après les fêtes : tout le monde essaie, peu s’y tiennent.

La raison ? L’IA générative, c’est fascinant, mais ça ne résout pas encore de vrais problèmes pour la majorité.

(Ca me rappelle un truc que quelqu’un disait même déjà tout à l’heure dans cet édito, non ? Ah : moi ? Ah oui : moi ! Une IA doit coller à un problème pour être adoptée par des gens ! Sinon, c’est comme pisser dans une viole de gambe -et je sais de quoi je parle, 14 ans de baroque au CNR de Lyon mon zozo !)

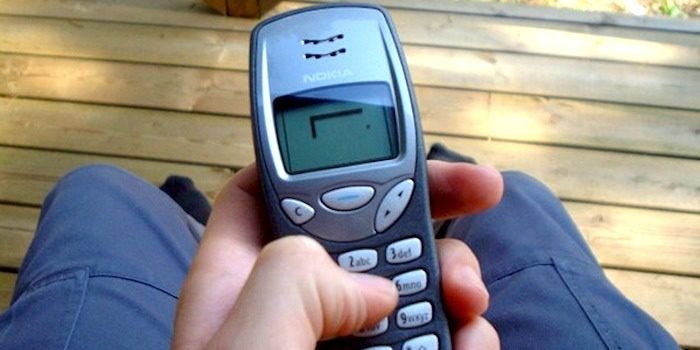

Evans compare ça à l’arrivée du smartphone : au début, on ne savait pas trop quoi en faire, à part jouer à Snake ou envoyer des SMS. Il a fallu des années pour que les usages explosent (Uber, Instagram, WhatsApp…). Pour l’IA, on en est encore au stade du “c’est cool, mais pourquoi faire ?”.

Ensuite, il démonte un mythe tenace : l’IA va-t-elle vraiment tuer tous les jobs ? Pas si simple.

Evans rappelle que chaque révolution technologique a généré son lot d’angoisses – l’automatisation, la robotisation, l’informatique… – et que, systématiquement, on a vu émerger de nouveaux métiers, de nouvelles industries. Il cite l’exemple de l’arrivée du PC dans les années 80 : “On pensait que les secrétaires allaient disparaître, mais on a surtout vu exploser le nombre de jobs dans la tech.”

Bref, l’IA va transformer le travail, oui, mais pas forcément le détruire.

Côté business, Evans est sans pitié : “Tout le monde investit dans l’IA, mais personne ne sait comment la rentabiliser.” Il balance des chiffres qui donnent le tournis : OpenAI valorisée à 350 milliards de dollars, des levées de fonds à gogo, mais un modèle économique encore flou.

Il compare ça à la bulle Internet des années 2000 : beaucoup d’argent, beaucoup d’espoirs, peu de certitudes. Il cite même un dirigeant de la Silicon Valley qui avoue : “On investit parce qu’on a peur que les autres aillent plus vite, pas parce qu’on sait où on va.” La FOMO, encore et toujours.

Evans s’attarde ensuite sur le côté “infrastructure” de l’IA. Il explique que, pour l’instant, l’IA, c’est surtout un immense chantier de cloud, de GPU, de data centers. Il cite le chiffre faramineux de Nvidia : 80% du marché mondial des puces IA, des milliards investis dans des fermes de serveurs.

Mais à quoi bon toute cette puissance si les usages ne suivent pas ? (Là encore, j’aurais pu l’écrire, hein, mais je vais rester humble et m’auto congratuler plus tard !)

Il compare ça à l’arrivée de l’électricité : au début, on a juste remplacé les lampes à gaz par des ampoules, sans imaginer tout ce qui allait suivre (machines, électroménager, cinéma…). Pour l’IA, on n’a pas encore trouvé “le use case” qui va tout changer… et même pas sûr qu’on ait déjà l’ampoule !

Il y a aussi la question de l’interface, un point sur lequel Evans insiste lourdement. Aujourd’hui, l’IA, c’est encore un truc de geek : il faut savoir prompter, comprendre les limites, jongler avec des outils pas toujours user-friendly.

Il imagine un futur où l’IA sera intégrée partout, de façon invisible, comme le correcteur automatique ou la recherche Google. Il cite l’exemple du smartphone : “Personne ne parle d’un ‘téléphone Internet’ aujourd’hui, c’est juste un téléphone.” L’IA, c’est pareil : elle va disparaître dans le décor, devenir une fonctionnalité comme une autre.

Où je pourrais en remettre une couche sur ma vision « voice + glasses » qui simplifiera beaucoup de choses en B2C… à voir pour le B2B, cependant !

Et la régulation, dans tout ça ? Evans n’élude pas le sujet. Il rappelle que l’Europe, fidèle à sa réputation de “régulateur du monde”, a déjà dégainé l’AI Act, pendant que les Américains hésitent, et que la Chine trace sa propre route. Il pose la question qui tue : “Peut-on vraiment réguler une techno qui évolue aussi vite ?”

Il cite l’exemple du RGPD, qui a certes protégé les données, mais aussi renforcé les géants du web au détriment des petits acteurs. Pour l’IA, le risque est le même : trop de régulation pourrait tuer l’innovation… ou la réserver aux plus gros.

Evans ne serait pas Evans s’il ne terminait pas sur une note d’humilité. (comme moi, mais c’est dingue !)

Il rappelle que toutes les prédictions sur la tech finissent par être ringardes. Il cite Bill Gates : “On surestime toujours l’impact d’une techno à court terme, mais on le sous-estime à long terme.” Pour lui, la vraie révolution de l’IA, c’est qu’on ne la verra pas venir.

Elle va s’infiltrer partout, changer nos habitudes sans qu’on s’en rende compte. Un peu comme l’électricité, Internet ou le smartphone : au début, tout le monde en parle, puis ça devient banal, indispensable, invisible.

Et attends : le cocktail IA + Robots, il n’en a pas parlé ? Grrrr !

Alors, la prochaine fois que tu entends un gourou annoncer que l’IA va “manger le monde”, demande-toi surtout : “Est-ce que je m’en rendrai compte quand ce sera le cas ?”

Et si tu veux briller en société, retiens cette punchline d’Evans : “L’IA, ce n’est pas une révolution, c’est une évolution qui va tout changer… sans faire de bruit.”

Pour creuser, va jeter un œil aux slides de Benedict Evans (https://www.ben-evans.com/presentations), à ses interventions sur YouTube ou à sa newsletter. C’est du petit lait… alors que moi, c’est du petit laid. (même pas vrai : suis grand !)

Google: I love this game!

Google a-t-il plié le game la semaine dernière ? C’est une vraie question pour une fois, parce qu’au-delà des « évolutions » dont on a maintenant l’habitude, les annonces faites lors de la conf I/O 2025 ont été d’une toute autre nature !

Alors je sais que tout a été écrit sur le sujet depuis quelques jours parce qu’il faut souvent être le « premier à s’exprimer », (ce qui a donné lieu à des critiques de Veo3 par des gens qui ne l’avaient pas testé, par exemple, très très LOL !) mais à tête reposée, prends le temps et le recul de lire ce que je te propose et dis-moi si c’est une évolution pépère ou un jump de ouf vers le futur ?

Imagine un monde où ton assistant codeur œuvre dans l'ombre pendant que tu savoures un mojito sous les derniers rayons du soleil, où tes vidéos TikTok s'assemblent d'elles-mêmes avec des effets sonores dignes des plus grandes productions hollywoodiennes, et où tes recherches Google se métamorphosent en conversations intimes avec un érudit bienveillant.

Bienvenue dans cette réalité post-I/O 2025, où Google vient de dévoiler ses dernières créations d'intelligence artificielle. Accroche-toi bien, car nous allons explorer comment Gemini, Veo 3, Flow et Jules s'apprêtent à bouleverser ton quotidien — ou à susciter en toi une inquiétude sourde, selon ta sensibilité aux mutations technologiques.

Gemini 2.5 : ce cerveau artificiel qui aspire à repenser l'obsolescence humaine… tout un programme !

La vedette incontestée de cette conférence demeure Gemini 2.5. Google a déployé son artillerie la plus sophistiquée avec deux modèles distincts : Gemini 2.5 Pro et Gemini 2.5 Flash.

Le premier, selon les benchmarks les plus rigoureux, surpasse tous ses concurrents en mathématiques et en programmation grâce à son mode Deep Think, cette faculté remarquable de prendre le temps de la réflexion.

En d'autres termes, il déploie des sous-requêtes parallèles comme autant de neurones interconnectés, tel un stagiaire prodige doté d'une patience infinie, avant de te livrer une réponse mûrement réfléchie.

Le second, Gemini Flash, incarne la version véloce et économe en énergie, parfaitement adaptée aux applications destinées au grand public.

Mais la véritable révolution réside dans leur nouvelle capacité à générer de l'audio natif, avec une subtilité qui confine à l'art. Finis les accents métalliques et les intonations mécaniques de Siri — Gemini 2.5 module le ton, l'émotion et même ces silences embarrassés qui ponctuent nos conversations humaines.

Et comme si cela ne suffisait pas, il comprend désormais les échanges en temps réel, filtrant avec une élégance remarquable les bruits parasites du monde environnant. Imagine pouvoir demander à ton enceinte Google de traduire une dispute familiale en direct… quoique, peut-être vaut-il mieux s'abstenir. J’ai eu l’occasion de sauver un échange avec un indien à la connexion discutable l’autre jour tandis que je luttais avec des perceuses d’un voisinage peu discrètes : énorme ! Sans les sous-titres simultanés je n’aurais pas compris un traitre mot de ce que me disait mon interlocuteur !!!

Veo 3 : c’est pas encore Spielberg dans ta poche, on ne comprend pas toujours son humour ni ses hallucinations, mais ça m’a assis !

Avec Veo 3, Google vient de terrasser définitivement le cinéma muet. (bon, on n’avait pas attendu Veo3, tu me diras !)

Ce modèle génère désormais des vidéos haute définition accompagnées d'un son presque parfaitement synchronisé. Tu saisis « un chat astronaute dans l'espace » et voilà ! Tu récupères une séquence en 4K ornée de ronronnements cosmiques et de grondements de propulseurs qui n’ont rien à envier des meilleurs trucages des meilleurs truquistes ! (la vidéo UK c’est parce que Veo3 est dispo là-bas… alors que chez nous toujours pas !)

Les démonstrations internes révèlent même des dialogues d'une crédibilité saisissante, grâce à un système qui analyse les mouvements labiaux avec une précision chirurgicale.

Bon, quand on a testé nous, faut avouer qu’on n’était pas à ce niveau de précision, et qu’on a un peu galéré avant de se régaler ! Et puis l’IA génère des séquences que tu ne peux pas « affiner », et des hallucinations peuvent encore pointer leur nez !

Et en Français, les défauts de langage et les accents sont parfois étonnants !

Pour la modique somme de 250 dollars mensuels (tarif Ultra AI), tu peux toi aussi inonder TikTok de vidéos de chiens prestidigitateurs. Voilà bien nos priorités contemporaines. Ou comment relire avec un nouvel angle l’article précédent sur l’ami Ben Evans !

Flow : Le studio de production artificielle qui fait trembler Hollywood

Flow représente la nouvelle arme secrète des créateurs de contenu complémentaire de Veo 3, en quelque sorte !

Cette synthèse harmonieuse de Veo (vidéo), Imagen (image) et Gemini (texte) te permet de réaliser un film en quelques clics, comme si tu tenais entre tes mains la baguette magique d'un réalisateur omnipotent.

Change les angles de caméra, ajoute des personnages générés ex nihilo, ajuste l'éclairage avec la minutie d'un chef opérateur... Le tout orchestré via une interface qui évoque un croisement entre Final Cut Pro et l'univers ludique d'un jeu vidéo et tu as l’univers de fou que te propose Google pour jouer à l’apprenti-Spielberg !

La fonctionnalité la plus révolutionnaire ? Flow TV, ce flux perpétuel de vidéos générées par la communauté où chaque création dévoile le prompt qui lui a donné naissance.

Imagine découvrir que le clip viral du mois a vu le jour grâce à la simple saisie « K-pop rencontre Godzilla dans une station spatiale ». De quoi donner des sueurs froides aux réalisateurs installés — et provoquer des nuits blanches chez les avocats spécialisés en droit d'auteur. (on en parle d’ailleurs dans la newsletter d’Elodie Hello Elo que tu peux retrouver par ici !)

Jules : le stagiaire artificiel qui besogne gratuitement sur ton GitHub… le stagiaire, quoi !

Fascinant pour les développeurs, inquiétant pour les autres : Jules incarne cet agent asynchrone qui manipule ton code à ta place, tel un fantôme bienveillant dans la machine.

Besoin de migrer une bibliothèque JavaScript ? Jules analyse le repository avec la méticulosité d'un archéologue, propose un plan détaillé digne d'un stratège militaire, et applique les modifications après ton approbation.

En version bêta publique, il maîtrise Python et JavaScript, avec une logique de tâches « fork-commit-pull request » qui évoque étrangement l'univers de Mr. Robot.

Google assure que Jules demeure sous contrôle humain... pour l'instant. Mais quand on découvre qu'il peut exécuter 42 requêtes parallèles grâce aux TPU Ironwood (ces créatures technologiques capables de 42,5 exaflops par pod -oui, là je crâne, mais je ne sais pas ce que ça veut dire en vrai !), on se dit que la Singularité pourrait bien pointer le bout de son nez dès 2026.

Google Beam : le FaceTime du futur qui t'observe en trois dimensions… alors moi, je n’en rêve pas, parce que je suis déjà en 4 ou 5 dimensions, surtout après un bon repas !

L'héritier du Project Starline fait son apparition sous l'appellation Google Beam.

Exit les appels vidéo bidimensionnels et ternes — ici, ton interlocuteur se matérialise en relief avec un réalisme troublant, chaque mouvement étant suivi avec une précision millimétrique. Cette prouesse technologique combine six caméras, de l'intelligence artificielle temps réel et un écran à champ lumineux.

Le résultat : une conversation où tu peux véritablement observer l'autre bâiller ou lever les yeux au ciel avec une authenticité déconcertante.

En partenariat avec HP, Google promet des appareils compacts d'ici la fin 2025. Parfait pour les réunions Zoom... ou les dîners familiaux holographiques. « Maman, t’as vu comme mon nouveau mec ressemble à Timothée Chalamet, avoue ? » (oui, j’ai des ados !)

AI Mode : Google Search devient ton professeur particulier, quelque peu pédant… enfin presque autant que moi !

Aux États-Unis, AI Mode remplace désormais les résultats classiques pour les requêtes complexes.

Saisir « Comparatif iPhone 25 versus Samsung Galaxy Z Fold 8 » déclenche un déluge d'analyses générées par Gemini 2.5, sources à l'appui.

Le système utilise le « query fan-out » : il lance dix sous-recherches en parallèle, puis compile l'ensemble avec la patience d'un bibliothécaire méticuleux.

En France ? Pas possible mon chéri ! Merci la CNIL et le RGPD. Tant pis pour nous, nous conservons nos bons vieux liens corrompus sponsorisés par les enseignes d'électronique grand public.

L'intelligence artificielle à deux vitesses et un chapelet d'interrogations ponctuent finalement ce I/O 2025…

Google vient de poser les fondations d'un monde où l'IA ne se contente plus de discourir — elle agit, elle crée, elle transforme.

Mais entre les abonnements Ultra à 250 dollars et les modèles open source en retrait, la fracture technologique s'annonce brutale. Et que dire de l'impact écologique des TPU Ironwood, ces géants énergétiques qui consomment l'équivalent d'une petite ville ? (il y a une offre actuellement à 120 dollars les 3 premiers mois pour les téméraires !)

Demeure cette question existentielle qui hante nos nuits : si Veo 3 peut générer un film sur des hamsters ninjas avec la facilité d'un souffle, qui a encore besoin de scénaristes ? La réponse se trouve peut-être dans l’expertise humaine, mon cochon !?

Eh oui parce qu’aussi bluffantes soient-elles, ces démos, elles requièrent quand même une expertise soit pour les prompter correctement, soit pour les corriger (prompter encore !), soit pour leur donner le petit plus qui fera d’elles des démos d’un réalisme dingue !

Plus l’IA est puissante, plus elle va révéler la compétence de ceux qui maîtrisent leur métier et qui donc peuvent apporter beaucoup à ces algos et ces GPUs !

Mistral et les agents

Mistral AI vient de dévoiler son API Agents, et tu pourrais bien reconsidérer ta perception de l'intelligence artificielle dans son ensemble.

Nous ne parlons plus ici de simples assistants conversationnels aux réponses convenues, mais d'agents autonomes dotés d'une véritable agency — capables de planifier avec la minutie d'un stratège, d'agir avec la détermination d'un exécutant, de collaborer comme les membres d'une équipe soudée et de s'adapter aux cas d'usage les plus concrets avec la souplesse d'un caméléon technologique.

Ce que propose Mistral, c'est une plateforme où tu peux aisément créer des agents qui exécutent du code Python dans un environnement sécurisé, génèrent des images via le modèle FLUX1.1 Ultra, effectuent des recherches web en temps réel ou fouillent dans une bibliothèque de documents cloud avec la persévérance d'un archiviste passionné.

Les chiffres parlent d'eux-mêmes avec l'éloquence des faits indiscutables : sur le benchmark SimpleQA, la précision de Mistral Large bondit spectaculairement de 23% à 75% dès lors qu'il accède à la recherche web, tandis que Mistral Medium réalise un saut encore plus impressionnant, passant de 22,08% à 82,32%.

Cette métamorphose de performance s'explique par la capacité remarquable de ces agents à aller puiser des informations fraîches aux sources les plus diverses, à vérifier les faits avec le scepticisme d'un journaliste d'investigation et à croiser les sources pour te fournir des réponses fiables et constamment actualisées.

Mais l'innovation ne s'arrête pas à ce seuil déjà prometteur. L'API Agents te permet de construire des workflows où plusieurs agents spécialisés travaillent ensemble dans une harmonie orchestrée, tel un ballet technologique où chaque danseur connaît parfaitement sa partition.

Dans le développement logiciel, par exemple, un agent peut interagir avec GitHub avec la fluidité d'un développeur chevronné, superviser un autre agent chargé d'écrire du code avec la vigilance d'un mentor bienveillant, et gérer automatiquement les tâches fastidieuses comme la création de branches ou les pull requests.

Pour la gestion de projets, tu peux transformer les transcriptions d'appels en documents de spécifications structurés, puis en tickets exploitables dans Linear, le tout sans la moindre intervention humaine — comme si un secrétaire invisible et infatigable s'occupait de toute l'administration.

Côté finance, un agent peut sourcer des métriques avec la précision d'un analyste expert, compiler des analyses avec la rigueur d'un consultant, et archiver les résultats dans le respect des standards de sécurité les plus élevés.

L'API se distingue également par sa mémoire persistante, cette faculté remarquable qui transforme l'interaction froide en relation authentique : chaque agent conserve le contexte de la conversation comme un ami fidèle, se souvient de tes préférences avec la sollicitude d'un majordome attentionné et des décisions prises avec la précision d'un archiviste méticuleux.

Cette continuité rend l'expérience infiniment plus fluide et personnalisée. Tu peux démarrer une conversation avec un agent spécifique ou directement avec un modèle et ses connecteurs, selon tes besoins du moment.

L'API gère l'historique avec une organisation parfaite, te permet de reprendre une discussion quand bon te semble, et propose même des réponses en streaming pour un maximum de réactivité — comme une conversation qui ne connaîtrait jamais d'interruption.

La gestion multi-agents constitue un autre atout majeur de cette architecture : tu peux orchestrer plusieurs agents qui se passent la main selon la tâche à accomplir, dans une chorégraphie technologique d'une rare élégance.

Imagine un assistant de voyage capable de planifier ton séjour avec l'expertise d'un guide expérimenté, réserver des hôtels avec l'efficacité d'un concierge professionnel, vérifier les avis avec la diligence d'un enquêteur et adapter le programme selon tes préférences avec la flexibilité d'un ami attentionné.

Un assistant nutritionnel, quant à lui, t'accompagnera pour fixer des objectifs réalistes, enregistrer tes repas avec la régularité d'un diététicien, te proposer des suggestions personnalisées et même te recommander des restaurants parfaitement adaptés à ton régime alimentaire.

Mistral a également pensé à la simplicité d'intégration avec cette pragmatisme qui caractérise les vraies innovations.

Quelques lignes de code Python suffisent pour créer un agent, choisir ses outils et définir ses capacités — comme si l'on assemblait un mécanisme d'horlogerie avec la simplicité d'un jeu de construction. Dans la vidéo qui suit, quelques lignes de code Monty Python en hommage au PSG….

Les tarifs adoptent une stratégie particulièrement agressive : Mistral Large s'affiche à 2 dollars le million de tokens en entrée et 6 dollars en sortie, les connecteurs comme Google Drive ou SharePoint coûtent la modique somme de 0,01 dollar par appel, et la recherche documentaire est facturée 6 dollars par million de tokens indexés. De quoi rendre cette technologie accessible à un grand nombre d'entreprises, depuis la startup audacieuse jusqu'à la multinationale établie.

Côté sécurité et confidentialité, l'intégration avec Le Chat Enterprise garantit que tes données demeurent protégées comme dans un coffre-fort numérique, ce qui constitue un point crucial pour les professionnels soucieux de la protection de leurs informations sensibles.

Mistral se positionne ainsi comme une alternative sérieuse et crédible à OpenAI et autres acteurs du secteur, misant sur un écosystème intégré, des connecteurs natifs et une adoption simplifiée qui démocratise l'accès à l'intelligence artificielle avancée.

Pour l'équipe de Mistral, il s'agit d'une « étape décisive dans l'évolution de l'IA vers des systèmes plus autonomes et capables d'actions concrètes » — une déclaration qui résonne comme un manifeste technologique.

Si tu souhaites passer de l'IA qui se contente de répondre à tes questions à celle qui agit véritablement pour toi avec l'efficacité d'un collaborateur dévoué, l'API Agents pourrait bien être l'outil qui va transformer tes workflows, automatiser tes processus les plus chronophages et t'ouvrir de nouvelles perspectives insoupçonnées, que tu sois développeur créatif, chef de projet visionnaire, analyste financier rigoureux ou entrepreneur audacieux.

Cette évolution marque peut-être le passage d'une intelligence artificielle passive, cantonnée au rôle de conseiller érudit, vers une IA active qui devient un véritable partenaire de travail — une transformation qui pourrait bien redéfinir notre rapport à la technologie et au travail lui-même… mais sur ce sujet, malheureusement, Mistral est loin d’être seul !

Les petites actualités de OpenAI ces derniers jours…

Dans l'écosystème numérique contemporain, ChatGPT transcende sa vocation première de simple assistant conversationnel pour embrasser une ambition bien plus vaste : celle de redéfinir nos interactions quotidiennes avec la technologie.

Tout d’abord avec l'émergence d'un commerce conversationnel…

L'intégration native d'une fonction Shopping transforme ChatGPT en conseiller commercial personnalisé. Cette innovation, déployée sans artifice publicitaire, révèle une approche raffinée : plutôt que de bombarder l'utilisateur de suggestions commerciales, l'outil présente des cartes produits élégamment illustrées, fruit d'une sélection indépendante basée sur des données structurées.

Tu peux désormais formuler une requête aussi naturelle que « trouve-moi la meilleure machine à expresso à moins de 200 dollars » et obtenir une réponse visuelle immédiate, complète d'évaluations et de liens d'achat directs.

Cette innovation, accessible à l'ensemble des utilisateurs planétaires via GPT 4o – qu'ils disposent d'un compte gratuit ou premium –, couvre initialement les secteurs phares de l'électronique, de la mode, de la beauté et de l'équipement domestique.

L'engouement se révèle spectaculaire : la recherche web via ChatGPT franchit désormais le milliard de requêtes hebdomadaires, témoignant d'un usage devenu central dans l'écosystème numérique.

Cette évolution ne s'arrête pas aux simples recommandations. OpenAI prépare secrètement un système d'achat intégré en partenariat avec Shopify, promettant une expérience d'achat entièrement contenue dans l'interface conversationnelle. Tu vas enfin (!) pouvoir explorer, comparer et finaliser tes achats sans jamais quitter ton dialogue avec l'IA ?

OpenAI cultive activement sa relation avec les commerçants en encourageant l'optimisation de leur visibilité numérique. Le crawler OAI-SearchBot indexe désormais les sites marchands, tandis qu'une fonctionnalité émergente permettra aux entreprises de soumettre directement leurs flux produits.

Cette stratégie garantit des catalogues perpétuellement actualisés, enrichis d'analytics intégrés pour tracer le trafic généré.

Cette perspective bouleverse les codes établis du e-commerce, transformant chaque conversation en potentiel parcours d'achat.

J’ai une expérience précise et personnelle de ce nouveau parcours : je ronfle ! Ma chère et tendre en a marre ! (moi aussi, mais je ne m’entends pas, hein !) Eh bien, après avoir écumé les propositions de Google sur des casques de nuit, c’est la compréhension de GPT4o qui lui a trouvé et recommandé un produit n’existant qu’en Angleterre, mais pertinent pour sa demande : pas de musique, des bruits blancs et qui s’arrêtent au bout d’un moment. Google avait déclaré forfait… ChatGPT a trouvé la perle rare !

Depuis, je dors bien mieux ! (enfin, elle, surtout !)

Dans un tout autre domaine, les ambitions ne s’arrêtent pas là pour Sam Altman et les 40 codeurs : elle passent parfois par des détails comme avec l'écosystème identitaire d'OpenAI.

Fort de ses 600 millions d'utilisateurs mensuels, OpenAI ambitionne de rivaliser avec les géants de l'authentification numérique. Le projet « Sign in with ChatGPT » témoigne d'une stratégie d'expansion audacieuse : ton identité ChatGPT pourrait bientôt te servir de passeport universel sur le web, à l'instar de ce que proposent Google, Meta ou Apple.

Cette initiative, encore en phase « test développeurs », révèle la volonté d'OpenAI de tisser un écosystème cohérent autour de son intelligence artificielle.

La révolution matérielle de Jony Ive : le tournant vers le hardware ! Ca aussi c’est de la news à fracasser l’univers de l’IA, non ?

L'acquisition d'IO Products et l'arrivée de Jony Ive marquent un tournant stratégique majeur. Cette collaboration, évaluée à 6,5 milliards de dollars, dépasse le simple recrutement d'un designer prestigieux.

Ive, l'architecte visuel des iPhone et iPad, apporte sa vision pour concevoir une nouvelle génération d'appareils pensés spécifiquement pour l'IA. Sam Altman évoque déjà un prototype qu'il qualifie de « gadget le plus cool que le monde ait jamais vu », suggérant une rupture technologique comparable à l'avènement du smartphone.

Cette alliance révèle une ambition fondamentale : libérer l'IA des contraintes des plateformes existantes. Plutôt que de dépendre des écosystèmes iOS ou Android, OpenAI aspire à créer ses propres supports matériels, optimisés pour ses algorithmes.

Et enfin, retour au software, parce que le futur, selon OpenAI, c’est aussi l'unification par GPT-5…

Sur le front logiciel, OpenAI poursuit sa quête de l'intelligence artificielle générale avec GPT-5. Ce modèle révolutionnaire promet d'unifier les capacités actuellement dispersées entre différents modèles spécialisés. Fini le basculement entre l'IA de code, de raisonnement ou de vision : GPT-5 aspire à exceller dans tous les domaines simultanément, grâce à une architecture multimodale intégrée.

Cette approche témoigne d'une maturité nouvelle dans la conception des systèmes d'IA. Plutôt que de multiplier les outils spécialisés, OpenAI mise sur la simplicité d'un assistant universel, capable de s'adapter à toutes tes demandes avec la même excellence.

Le MCP : quand l'IA met les mains dans le cambouis

Tu as déjà essayé de faire comprendre à ChatGPT que tu voulais qu'il consulte ton agenda Google pour planifier une réunion ? Ou demandé à Claude de jeter un œil à tes derniers messages Slack pour t'aider à rédiger un rapport ?

Si oui, tu as probablement fini par te rendre compte que ces IA, pourtant brillantes, étaient un peu comme des génies enfermés dans une lampe : puissantes, certes, mais cruellement déconnectées du monde réel.

C'est exactement ce problème que vient résoudre le Model Context Protocol, ou MCP pour les intimes, une innovation qui transforme actuellement l'écosystème de l'intelligence artificielle de fond en comble.

Pour comprendre l'ampleur de cette révolution, il faut d'abord saisir le paradoxe qui rongeait l'IA jusqu'à présent.

D'un côté, nous avions des modèles de langage de plus en plus sophistiqués, capables de raisonner, d'analyser et de créer avec une finesse stupéfiante.

De l'autre, ces mêmes systèmes restaient prisonniers de leurs propres silos informationnels, incapables d'accéder aux données fraîches ou d'interagir avec les outils que nous utilisons quotidiennement.

Cette limitation transformait même les IA les plus avancées en "génies diminués" : brillants sur le papier, mais inutiles pour les tâches concrètes.

Cette analogie pour expliquer la différence entre les APIs traditionnelles et le MCP est particulièrement éclairante. Imagine-toi au restaurant : avec une API classique, tu reçois simplement un menu, tu passes commande et tu attends ton plat sans jamais savoir ce qui se passe en cuisine. Tout est évidemment prévisible, mais aussi terriblement cloisonné, rigide presque.

Avec le MCP, c'est comme si le chef t'invitait directement dans sa cuisine pour que tu puisses voir quels ingrédients sont disponibles, comprendre les techniques utilisées, et même suggérer des modifications à la volée.

Cette approche révolutionnaire permet aux agents IA de découvrir et d'adapter leur comportement en temps réel, plutôt que de se contenter d'exécuter des commandes préprogrammées.

Ce qui rend cette innovation encore plus remarquable, c'est la vitesse fulgurante avec laquelle elle s'est imposée dans l'industrie.

Lancé par Anthropic en novembre 2024, le MCP a été adopté en quelques mois seulement par tous les géants de la tech. OpenAI a surpris tout le monde en mars 2025 en annonçant l'intégration du protocole dans ses outils, y compris l'application desktop de ChatGPT.

Google DeepMind a emboîté le pas en avril 2025, promettant d'implémenter le MCP dans ses prochains modèles Gemini.

Même Microsoft, avec son écosystème Copilot, s'est rallié à cette norme ouverte. Cette adoption unanime témoigne d'un besoin industriel criant et atteste surtout de la qualité technique du protocole proposé par Anthropic.

Pour mesurer l'impact concret de cette technologie, il suffit de regarder les applications qui émergent déjà.

Chez Runbear, une entreprise spécialisée dans l'automatisation des workflows, les équipes utilisent désormais des agents IA capables de programmer des réunions en croisant automatiquement les agendas Google Calendar de tous les participants, de réserver une salle et de générer un lien Google Meet, le tout depuis Slack.

Fini les allers-retours fastidieux pour trouver un créneau libre !

Dans un autre registre, les analystes non-techniques peuvent maintenant interroger des bases de données complexes en langage naturel grâce au serveur MCP BigQuery, posant simplement des questions comme "Comment est-ce que nos publicités LinkedIn de mars se sont comportées par rapport à février ?".

L'aspect technique du MCP mérite qu'on s'y attarde, car il révèle une approche architecturale particulièrement ingénieuse.

Contrairement aux solutions propriétaires précédentes, comme les plugins ChatGPT ou l'API de "function calling" d'OpenAI, le MCP adopte une approche universelle inspirée du Language Server Protocol qui avait révolutionné les éditeurs de code.

Le protocole utilise des messages JSON-RPC 2.0 pour établir une communication standardisée entre les clients (les applications IA) et les serveurs (les sources de données et outils) -ne me demande pas de te dire d’oû vient le nom de ce protocole !!

Cette architecture résout élégamment ce que les développeurs appellent le "problème M×N" : au lieu de créer des intégrations spécifiques entre chaque IA et chaque outil, il suffit maintenant que chaque système implémente le MCP une seule fois pour être compatible avec tous les autres. Et ça, c’est malin !

La sécurité constitue évidemment un enjeu majeur quand on permet à des IA d'accéder à des données sensibles et d'exécuter des actions dans des systèmes critiques.

Microsoft, qui prépare l'intégration du MCP dans Windows 11, a d'ailleurs conçu une architecture de sécurité spécifique qui comprend un proxy MCP centralisé pour gérer les consentements et appliquer les politiques de sécurité.

L'entreprise impose trois principes fondamentaux : un socle de sécurité commun validé par Microsoft, un consentement explicite de l'utilisateur pour chaque action sensible, et l'application stricte du principe du moindre privilège.

Cette approche "secure by default" montre que l'industrie a tiré les leçons des déboires passés avec l'IA et prend au sérieux la question de la protection des données.

L'écosystème MCP explose littéralement avec des centaines de serveurs développés par la communauté en quelques mois seulement.

Anthropic fournit des implémentations de référence pour les systèmes les plus courants comme Google Drive, Slack, GitHub, Git, PostgreSQL ou encore Puppeteer pour l'automatisation de navigateurs web.

GenomOncology a même développé BioMCP, une version spécialisée pour les données biomédicales qui permet aux IA d'accéder aux essais cliniques, aux données génétiques et à la recherche médicale publiée.

Cette diversification rapide illustre la soif d'intégration qui existait dans l'industrie et la facilité avec laquelle le MCP permet de combler ces lacunes.

L'adoption du MCP par l'industrie s'accompagne d'un changement philosophique profond dans l'approche de l'IA. Plutôt que de se concentrer uniquement sur la performance brute des modèles, les entreprises réalisent que la valeur réside dans la capacité à connecter intelligemment ces modèles aux données et outils existants.

Cette évolution rappelle curieusement l'histoire d'ODBC dans les années 90, ce standard qui avait révolutionné l'accès aux bases de données en créant une interface universelle.

Comme le note un observateur de l'industrie, "le MCP fait pour l'IA ce qu'ODBC a fait pour les bases de données : il transforme un problème M×N en un problème M+N". (j’adore les blagues de codeurs ou d’ingénieurs parce que je ne les comprends jamais !)

Les implications business de cette standardisation sont considérables. Block, la société derrière Square, utilise déjà le MCP pour connecter son assistant IA interne aux données financières de l'entreprise.

Apollo s'en sert pour relier ses agents à des référentiels de contenu professionnels. Ces premiers déploiements en entreprise montrent que le MCP n'est pas juste un gadget technique, mais un véritable catalyseur de transformation digitale qui permet enfin aux IA d'avoir un impact concret sur les processus métier.

Ce qui fascine dans cette histoire, c'est la rapidité avec laquelle un standard ouvert a réussi à fédérer des concurrents acharnés.

OpenAI adoptant une technologie développée par Anthropic, c'est un peu comme si Apple décidait soudain d'utiliser Android dans ses iPhone !

Cette convergence inédite suggère que l'industrie a compris que la véritable bataille ne se joue plus sur la propriété des protocoles, mais sur la capacité à créer des écosystèmes ouverts et interopérables qui maximisent la valeur pour les utilisateurs finaux.

Alors que nous entrons dans cette nouvelle ère de l'IA connectée, une question passionnante se dessine : et si le MCP n'était que le début d'un mouvement plus vaste vers des systèmes d'intelligence artificielle véritablement intégrés dans le tissu numérique de nos organisations ?

Dans un monde où chaque application, chaque base de données, chaque capteur pourrait dialoguer naturellement avec des agents IA, quelles seront les prochaines frontières à repousser pour créer une intelligence ambiante vraiment utile ?

Les pirates sont à la page de l’IA !

Dans l'effervescence technologique contemporaine, une menace insidieuse se dissimule derrière l'attrait irrésistible des dernières innovations en intelligence artificielle. Cette fascination pour les outils révolutionnaires pourrait bien te coûter une fortune considérable.

Tu connais cette sensation grisante qui t'envahit à la découverte d'un nouvel outil prometteur ? Cette excitation face à un prétendu clone de ChatGPT, gratuit et supposément plus performant, ou devant InVideo AI qui promet de transformer tes montages vidéo sans effort particulier ?

Cette euphorie technologique constitue désormais le terrain de chasse privilégié d'une nouvelle génération de cybercriminels particulièrement retors.

Ces dernières semaines ont révélé une campagne d'envergure orchestrée par des pirates informatiques d'un genre nouveau. Leur stratégie consiste en la conception de fausses versions d'outils à la mode, dissimulant des rançongiciels sophistiqués derrière des interfaces soigneusement léchées.

Tu crois télécharger un assistant révolutionnaire, mais tu installes en réalité un programme malveillant qui prendra ton système en otage.

Les chercheurs de Cisco Talos ont mis au jour ce réseau tentaculaire : des sites comme « chat-gpt-pc[.]online » ou « novaleadsai[.]com » prolifèrent sur la toile, arborant une crédibilité trompeuse.

Derrière ces façades numériques se cache « CyberLock », un malware au nom évocateur qui chiffre impitoyablement tes fichiers avant d'exiger une rançon de 50 000 dollars en Monero.

Cette menace dépasse largement le simple chiffrement de données. Les fichiers trop volumineux sont purement et simplement détruits. Le système Windows voit Son interface graphique sabotée pour le rendre totalement inutilisable. Cette approche systémique transforme ton environnement numérique en territoire hostile.

Le plus troublant réside dans leur maîtrise des techniques de visibilité en ligne. Grâce à des stratégies SEO perfectionnées, ces sites malveillants s'affichent en première position lors de recherches apparemment innocentes comme « ChatGPT download for PC ».

Cette manipulation du référencement s'accompagne d'une diffusion publicitaire massive sur Facebook, Telegram et LinkedIn, transformant les plateformes sociales en vecteurs de contamination.

Leur approche révèle une compréhension fine de leur cible : les professionnels en quête d'automatisation, développeurs, marketeurs, créateurs de contenu, tous pris dans la frénésie de l'intelligence artificielle.

Ces faux outils séduisent par leur apparence irréprochable : sites élégants, logos soignés, formulaires crédibles. L'illusion atteint une perfection redoutable, masquant efficacement les intentions criminelles.

Face à cette sophistication malveillante, la prudence devient ton meilleur allié, comme toujours ! Un esprit critique… le pouvoir de se dire que si c’est « trop beau », c’est louche ! Privilégie toujours les sources officielles pour tes téléchargements d'outils IA. Comme pour tout le reste d’ailleurs !

Méfie-toi des liens sponsorisés suspects et des recommandations douteuses sur les forums. Vérifie scrupuleusement les URL, examine attentivement avant de cliquer.

`Cette vigilance élémentaire peut t'épargner la découverte amère que ton assistant IA tant désiré n'était qu'un ransomware déguisé en sirène digitale !

L'intelligence artificielle dessine effectivement un nouveau Far West numérique, où la prudence distingue les pionniers avisés des victimes imprudentes.

Tesla lance ses robotaxis le 12 juin

Tandis que Musk vient d'abandonner son rôle d'employé spécial auprès de l'administration Trump pour se "consacrer entièrement au travail en dormant dans les usines et les salles de serveurs", Tesla s'apprête à franchir un seuil décisif qui pourrait bien sceller le destin de l'entreprise.

Le 12 juin 2025, Austin au Texas se muera en théâtre d'un pari technologique et financier titanesque : le déploiement des premiers robotaxis autonomes de Tesla, des Model Y sans conducteur qui transporteront de véritables passagers contre rémunération.

Bien que cette échéance ait suscité d'âpres débats internes chez Tesla et demeure susceptible de modifications, l'annonce marque une inflexion majeure dans la stratégie de Musk, qui a engagé toute la crédibilité de son empire automobile sur cette promesse ressassée depuis bientôt une décennie.

Depuis plusieurs jours déjà, Tesla expérimente ses véhicules autonomes sur les artères publiques d'Austin "sans âme qui vive au siège du conducteur", comme l'a attesté Musk lui-même sur X, ajoutant avec son aplomb coutumier que ces essais se déroulent "sans le moindre incident" et qu'ils arrivent "un mois en avance sur le calendrier".

Cette déclaration peut prêter à sourire quand on se souvient que Tesla promettait déjà un million de robotaxis en circulation dès 2020.

Mais cette fois, l'enjeu diffère radicalement : il ne s'agit plus de chimères futuristes, mais de véhicules tangibles transportant de vrais clients contre de l'argent sonnant et trébuchant.

Le lancement s'amorcera modestement avec une flotte de 10 à 20 Model Y dotées de la technologie "FSD Unsupervised" (Full Self-Driving sans supervision), selon les déclarations de Musk lors d'un entretien accordé à CNBC.

Ces véhicules, légèrement remaniés par rapport aux versions commerciales, évolueront dans un périmètre géographique circonscrit d'Austin, une stratégie de "geofencing" prudente qui permet d'éprouver la technologie dans un environnement maîtrisé.

L'objectif affiché s'avère ambitieux : si tout se déroule harmonieusement, Tesla entend rapidement étendre la flotte à des milliers de véhicules et conquérir d'autres villes américaines comme San Francisco, Los Angeles et San Antonio.

Ce qui distingue cette initiative des précédentes tentatives de Tesla, c'est l'absence totale de conducteur de sécurité dans les véhicules.

Contrairement aux tests antérieurs où un humain demeurait prêt à reprendre les commandes, les robotaxis d'Austin fonctionneront sous supervision distante uniquement. Des téléopérateurs surveilleront les véhicules depuis les bureaux de Tesla, prêts à intervenir si une situation complexe se présente, mais sans pouvoir physiquement saisir le volant comme le pratiquent les concurrents. Cette approche incarne un pari technologique audacieux, mais aussi un risque considérable en termes de responsabilité juridique.

Alors Austin serait-elle le laboratoire idéal ou un terrain miné à taille réelle ?

Le choix d'Austin pour ce lancement ne relève pas du hasard. Contrairement à la Californie où Waymo et d'autres rivaux ont dû naviguer dans un dédale réglementaire complexe, le Texas adopte une approche ultra-libérale en matière de véhicules autonomes.

Depuis 2017, la loi texane autorise les entreprises à déployer des véhicules autonomes sans supervision préalable de l'État, à condition qu'ils soient assurés et immatriculés.

Cette philosophie du "laisser-faire" reflète l'esprit texan : comme l'expliquait le sénateur Kelly Hancock, architecte de cette législation, "nous voulions éviter toute entrave à l'innovation et laisser le marché évoluer librement".

Cette liberté réglementaire confère à Tesla un avantage considérable, mais elle soulève également des interrogations légitimes sur la sécurité publique. Austin a déjà essuyé des incidents avec d'autres véhicules autonomes : en 2023, une flotte de robotaxis Cruise a paralysé une artère près de l'Université du Texas, créant un chaos routier.

Les autorités locales ont enregistré 78 plaintes liées aux véhicules autonomes, selon les données officielles de la ville. Plus préoccupant encore, les départements d'urgence d'Austin affirment n'avoir reçu aucune formation spécifique de Tesla, contrairement aux protocoles établis par Waymo et Zoox qui organisent systématiquement des sessions de formation avec les premiers secours avant leurs lancements.

Cette situation met en lumière un paradoxe : alors que Tesla se lance dans l'aventure robotaxi avec une confiance affichée, les autorités locales avouent ignorer les détails du niveau d'autonomie que Tesla utilisera.

Les véhicules fonctionneront-ils selon les standards "Level 4" de l'industrie automobile (autonomie complète dans certaines conditions) ou "Level 5" (autonomie totale) ?

Tesla demeure évasive sur cette question cruciale, alimentant les interrogations sur la maturité réelle de sa technologie.

L'arrivée de Tesla sur le marché des robotaxis s'effectue dans un contexte où Alphabet's Waymo domine déjà le secteur avec une expérience opérationnelle concrète. Waymo effectue actuellement 250 000 trajets rémunérés par semaine et opère déjà à Austin depuis mars 2025, en partenariat avec Uber.

Les utilisateurs peuvent déjà commander un robotaxi Waymo via l'application Uber dans 37 miles carrés d'Austin, de Hyde Park au centre-ville jusqu'à Montopolis.

La différence d'approche entre les deux géants technologiques frappe par son amplitude.

Waymo mise sur une technologie sophistiquée combinant LiDAR, caméras haute définition et cartographie détaillée pour créer une représentation précise de l'environnement.

Tesla, au contraire, privilégie une approche "vision-only" basée exclusivement sur des caméras et l'intelligence artificielle, sans cartographie préalable détaillée. Cette philosophie reflète la vision de Musk selon laquelle "le LiDAR n'est qu'une béquille" pour les véhicules autonomes.

Paradoxalement, Tesla utilise bel et bien du LiDAR, mais uniquement pour valider la précision de son système de vision lors des tests.

L'entreprise a d'ailleurs acquis pour environ 2 millions de dollars d'équipements LiDAR auprès de Luminar pour équiper ses "véhicules de validation de flotte" qui sillonnent les routes avec des plaques d'immatriculation de constructeur.

Ces véhicules collectent des données cruciales pour entraîner les réseaux de neurones de Tesla, mais le système déployé commercialement s'appuiera exclusivement sur les caméras.

Avant de conquérir les voies publiques d'Austin, Tesla a métamorphosé ses propres usines en laboratoires grandeur nature pour éprouver sa technologie FSD Unsupervised.

À Giga Texas et à Fremont, les véhicules tout juste sortis des chaînes de production naviguent automatiquement jusqu'aux parkings de livraison, parcourant jusqu'à 1,4 mile sur le terrain de l'usine sans conducteur.

Ces manœuvres, qui totalisent déjà plus de 50 000 miles parcourus, permettent d'affiner les algorithmes dans des conditions réelles où coexistent piétons, véhicules industriels, équipements de construction et circulation normale.

Cette stratégie d'entraînement interne présente l'avantage de générer d'énormes quantités de données dans un environnement maîtrisé. Chaque trajet autonome alimente les réseaux de neurones de Tesla, créant un cercle vertueux d'amélioration continue.

Lara Trump, lors d'une visite récente à Giga Texas retransmise sur FOX News, s'est montrée impressionnée par ces démonstrations, commentant en direct : "Seul Elon Musk peut accomplir cela". Cette reconnaissance médiatique positive contraste avec les critiques habituelles dont fait l'objet Tesla dans les médias américains.

Les véhicules autonomes de Tesla dans ses usines arborent une signalétique visuelle particulière : un éclairage ambiant multicolore qui pourrait devenir un marqueur distinctif des véhicules en mode FSD Unsupervised.

Cette fonctionnalité, visible dans les vidéos promotionnelles, pourrait servir à identifier clairement les véhicules autonomes sur la voie publique, facilitant leur reconnaissance par les autres usagers de la route et les services d'urgence.

Au-delà des prouesses techniques, le lancement des robotaxis représente un enjeu financier colossal pour Tesla. L'entreprise a réorienté sa stratégie de développement, abandonnant ses projets de voiture électrique abordable pour se concentrer sur les robotaxis et ses robots humanoïdes Optimus.

Cette stratégie du "quitte ou double" reflète la conviction de Musk que l'avenir de Tesla réside dans l'intelligence artificielle et l'autonomie plutôt que dans la simple fabrication automobile.

Les analystes de Morningstar estiment que Tesla pourrait conduire jusqu'à 4 500 tests par mois avec ses 10 robotaxis initiaux, en supposant 15 trajets quotidiens par véhicule.

Cette cadence d'essais devrait permettre d'identifier et de corriger rapidement les défaillances, contrairement à une flotte plus réduite. Dan Ives de Wedbush voit dans ce lancement "l'âge d'or de l'autonomie" pour Tesla, estimant que le 12 juin marquera "un chapitre pivot de croissance".

Cependant, les mêmes analystes demeurent prudents sur les perspectives à court terme. Morningstar maintient un objectif de cours de 250 dollars pour Tesla mais anticipe que le déploiement commercial multi-villes ne se concrétisera pas avant 2028.

Cette prudence reflète les défis techniques et réglementaires considérables qui attendent Tesla, même si les tests d'Austin se déroulent sans accroc.

L'approche de Tesla contraste radicalement avec celle de ses concurrents en termes de préparation et de communication avec les autorités locales. Waymo et Zoox organisent systématiquement des formations avec les services d'urgence des mois avant leurs lancements, fournissant des guides détaillés de plusieurs dizaines de pages expliquant comment interagir avec leurs véhicules en cas d'incident. Tesla, elle, semble privilégier la vélocité d'exécution à la concertation préalable.

Cette précipitation inquiète certains observateurs du secteur. Un commentaire particulièrement critique sur Electrek, site spécialisé dans les véhicules électriques, souligne l'abîme technologique entre Tesla et Waymo : "J'ai utilisé les robotaxis Waymo à San Francisco et Los Angeles et je suis époustouflé par leurs performances.

Même la nuit dans un brouillard dense à San Francisco, les voitures détectaient des piétons sur des rues non éclairées que je ne discernais même pas. FSD n'évolue pas dans la même catégorie que Waymo".

Cette critique met le doigt sur une différence fondamentale : alors que Waymo a accumulé des dizaines de millions de miles d'expérience en conditions réelles et fonctionne commercialement depuis plusieurs années, Tesla commence tout juste ses tests sans conducteur quelques semaines avant le lancement commercial.

L'audace de cette approche pourrait soit révolutionner le secteur, soit exposer Tesla à des risques considérables en termes d'image et de responsabilité juridique.

Le fait que Tesla ait testé ses véhicules sans conducteur seulement "quelques jours" avant l'annonce du lancement suscite des interrogations légitimes sur la maturité de la technologie.

Comme le souligne l'expert d'Electrek : "Ce n'est pas une victoire d'avoir zéro incident après quelques jours de tests. Il faut zéro incident sur des mois d'essais et des centaines de milliers de miles avant un lancement commercial."

Si Tesla réussit son pari austinien, les implications dépasseront largement le secteur automobile. L'entreprise projette de faire fonctionner des millions de véhicules de manière autonome d'ici deux ans, une ambition qui transformerait radicalement les transports urbains.

L'objectif ultime demeure le déploiement des "Cybercabs", des robotaxis dédiés sans volant ni pédales dont la production est prévue avant 2027, mais le succès du pilote d'Austin avec des Model Y modifiées constitue un préalable indispensable.

Au-delà des enjeux technologiques, ce lancement éprouve aussi l'acceptation sociale des véhicules autonomes. Austin, avec ses 37 miles carrés d'expérimentation et sa population tech-friendly, offre un terrain d'essai idéal pour mesurer les réactions du public.

Si les habitants d’Austin adoptent massivement les robotaxis Tesla, cela pourrait accélérer le déploiement dans d'autres métropoles américaines et influencer les régulateurs encore hésitants.

Mais le véritable test ne fait que commencer. Après des années de promesses et d'atermoiements, Musk n'a plus droit à l'erreur. Comme il l'a lui-même reconnu lors de l'entretien CNBC : "failure is not an option!".

Cette phrase résume parfaitement l'enjeu : Tesla joue sa crédibilité technologique, sa valorisation boursière et son avenir sur les routes d'Austin. Dans quelques semaines, on saura si le génie autoproclamé de l'innovation aura tenu parole ou si les robotaxis Tesla rejoindront la longue liste des promesses non tenues d'Elon Musk.

Une chose demeure certaine : l'industrie automobile tout entière observe, fascinée et inquiète, cette expérimentation grandeur nature qui pourrait redéfinir notre rapport à la mobilité urbaine.

Dire qu’en France, nous avions des champions comme Navia qu’on n’a pas su faire passer à l’échelle… Bref.

Meta transforme l'expérience Quest avec des photos Instagram en 3D et une interface révolutionnaire

Meta vient d'orchestrer une révolution silencieuse dans l'univers de la réalité virtuelle avec sa mise à jour Horizon OS v77 pour les casques Quest.

Cette nouvelle version introduit deux innovations majeures qui pourraient bien métamorphoser ta façon de consommer les réseaux sociaux en VR : la transformation automatique des photos Instagram en images 3D immersives et une interface utilisateur entièrement repensée baptisée Navigator.

Ces avancées, déployées progressivement depuis le 26 avril 2025 via le canal de test public, marquent l'une des évolutions les plus ambitieuses de l'écosystème Meta depuis des années.

La fonctionnalité la plus spectaculaire de cette mise à jour concerne sans doute la transformation des photos Instagram en expériences 3D. Meta a développé des algorithmes de synthèse de vue par intelligence artificielle qui analysent chaque pixel des images 2D pour leur conférer une profondeur immersive.

Cette technologie fonctionne sans nécessiter d'appareils photo 3D spécialisés, ce qui représente un bond technologique considérable. Comme l'explique Meta dans son blog officiel, "nos algorithmes d'intelligence artificielle recréent la profondeur des photos Instagram, sans avoir besoin de caméra 3D".

Cette prouesse technique repose sur des réseaux de neurones artificiels sophistiqués qui estiment la profondeur stéréoscopique et reconstruisent les images pour correspondre au positionnement des yeux humains.

La technologie va même au-delà de la simple conversion d'images : elle permet de créer des environnements 3D navigables à partir d'une seule image, en générant des panoramas cohérents grâce à des modèles de diffusion pré-entraînés.

Ces environnements immersifs sont ensuite rendus en utilisant la technique du Gaussian splatting, permettant aux utilisateurs d'explorer virtuellement des espaces définis à partir de simples photographies.

L'impact de cette innovation dépasse largement le simple gadget technologique. En transformant automatiquement le contenu 2D existant en expériences immersives, Meta pose les bases d'un futur où les réseaux sociaux traditionnels évoluent naturellement vers des plateformes spatialisées.

Cette approche rappelle d'ailleurs les premières expérimentations de Meta avec les photos 3D sur Facebook en 2018, mais avec une sophistication technique incomparable. Tu te souviens peut-être de ces premiers essais qui demandaient des appareils photo compatibles et donnaient des résultats souvent décevants ? Eh bien, oublie tout cela : l'IA fait désormais le travail à ta place, et le résultat promet d'être saisissant.

Parallèlement à cette révolution visuelle, Meta dévoile Navigator, une refonte complète de l'interface utilisateur des casques Quest qui abandonne le système de dock traditionnel au profit d'une superposition translucide révolutionnaire.

Cette nouvelle interface, présentée lors de Meta Connect 2024, a été conçue en s'appuyant sur dix années de retours utilisateurs et représente la plus grande évolution de l'interface Quest depuis le lancement du Quest 2.

Navigator transforme radicalement la navigation en regroupant toutes les fonctions système - bibliothèque, contrôles rapides, appareil photo, contacts, notifications - dans une seule superposition accessible à tout moment.

Fini le menu universel que tu connaissais : place à un lanceur de type overlay qui s'inspire clairement des interfaces Apple, avec une ergonomie repensée pour l'informatique spatiale. Tu peux désormais épingler jusqu'à dix applications favorites pour un accès immédiat, et l'interface s'ouvre d'un simple clic sur le bouton Meta de ton contrôleur droit.

Cette évolution s'inscrit dans une démarche plus large de Meta pour transformer Horizon OS en véritable système d'exploitation multitâche. La nouvelle interface permet d'ouvrir des applications et de modifier des paramètres comme la luminosité sans perturber tes fenêtres 2D actives.

C'est un peu comme si Windows et macOS avaient eu un enfant élevé dans l'espace - pratique, intuitif, et parfaitement adapté aux contraintes de la réalité virtuelle. Meta a même intégré des indicateurs de confidentialité sophistiqués : un point violet apparaît quand des autorisations comme le microphone ou les données spatiales sont utilisées, tandis qu'un point orange signale l'activation de paramètres système spéciaux.

La mise à jour v77 ne se contente pas de ces deux fonctionnalités phares. Elle introduit une série d'améliorations techniques qui révolutionnent l'expérience utilisateur au quotidien. Le support expérimental du Bluetooth Low Energy Audio représente une avancée majeure pour la qualité sonore en VR. Cette technologie promet de résoudre enfin le problème de latence audio qui rendait les écouteurs Bluetooth inadaptés aux jeux d'action et de rythme sur Quest.

La migration vers Android 14 constitue également un changement fondamental sous le capot. Cette évolution technique devrait considérablement réduire la latence audio Bluetooth, rendant enfin les écouteurs sans fil véritablement adaptés à l'usage intensif en réalité virtuelle.

Imagine pouvoir jouer à Beat Saber avec tes AirPods sans décalage - c'est exactement ce que vise cette amélioration.

Meta a aussi repensé la gestion des fenêtres spatiales avec de nouvelles options révolutionnaires.

Tu peux maintenant choisir qu'une fenêtre t'accompagne dans tes déplacements grâce à la fonction "Tether", l'attacher à un endroit précis avec "Pin", ou même la partager avec d'autres utilisateurs via "Share". Cette flexibilité transforme complètement la façon dont tu peux organiser ton espace de travail virtuel.

Meta envisage même de lever la limite actuelle de trois fenêtres spatiales, ce qui pourrait transformer Horizon OS en système multitâche complet utilisable même dans Horizon Worlds.

L'application Horizon for PC unifie désormais Meta Quest Link, le casting et le bureau à distance en une seule solution. Cette consolidation simplifie considérablement la connexion entre ton casque et ton ordinateur, créant un écosystème plus cohérent et plus aisé à utiliser.

Ces innovations techniques dissimulent une ambition bien plus large : positionner Meta comme leader de l'informatique spatiale de demain. L'entreprise travaille déjà sur des fonctionnalités futuristes comme l'authentification par suivi oculaire, baptisée "Enrôlement Facial".

Cette technologie permettrait de déverrouiller ton compte, d'accéder à des applications et d'autoriser des achats simplement en regardant ton casque. Bien que probablement destinée au futur Quest 4 plutôt qu'au Quest Pro désormais abandonné, cette innovation montre la direction prise par Meta.

Le partage de fenêtres entre utilisateurs, similaire au SharePlay d'Apple sur visionOS, arrive également dans les tuyaux. Cette fonctionnalité facilitera la collaboration et le partage d'informations en environnement virtuel, transformant potentiellement la façon dont nous travaillons et ‘socialisons’ en VR.

Ces avancées s'inscrivent dans la stratégie globale de Meta pour le métavers, concept que Mark Zuckerberg décrit comme "un monde numérique interconnecté, qui fait le pont entre VR et AR mais aussi des plateformes plus familières comme ton téléphone et ton ordinateur".

Avec plus de trois milliards d'utilisateurs sur ses plateformes, Meta dispose d'une base utilisateur massive pour tester et déployer ces innovations à grande échelle.

Rappelle-toi qu'il y a encore quinze ans, l'idée de regarder des vidéos sur un téléphone semblait futuriste à beaucoup de monde. Aujourd'hui, TikTok et Instagram Reels dominent nos écrans. L'évolution technologique a cette particularité fascinante de transformer l'impossible d'hier en évidence d'aujourd'hui.

Et si les paris de Meta sur l'informatique spatiale se révèlent justes, dans quelques années, consulter tes photos Instagram en 2D pourrait te sembler aussi archaïque que regarder la télévision en noir et blanc.

Dans un registre voisin, Meta vient de faire sauter le verrou qui l’éloignait du secteur de la défense en s’acoquinant avec le sous-traitant militaire Anduril pour développer des casques de réalité mixte alimentés par l’IA destinés à l’armée américaine.

Ces casques, baptisés "EagleEye", utiliseront la plateforme Lattice d’Anduril pour fournir aux soldats une vision améliorée et un contrôle intuitif des systèmes autonomes en temps réel sur le champ de bataille. Ce projet vise à adapter des technologies initialement conçues pour le grand public à un usage militaire, marquant une nouvelle étape dans l’intégration des géants tech comme Meta dans la défense américaine…

Le marché grand public pour ces histoires d’immersion serait-il finalement un peu trop petit pour Meta ?

Elon et les 1000 fusées (c’est presque le titre de mon prochain bouquin !)

Alien Musk vient d'annoncer son projet le plus démesuré à ce jour : construire ce qu'il appelle un "gigabay", littéralement la plus grande structure au monde -selon certains critères, capable d'abriter jusqu'à 1000 fusées Starship de 120 mètres de haut chacune.

Ce projet pharaonique s'inscrit dans sa vision obsessionnelle de "rendre la vie multiplanétaire" et transforme progressivement le Texas en véritable empire spatial personnel.

Lors d'une présentation récente à ses employés de Starbase au Texas, l'homme le plus riche du monde a détaillé cette structure qu'il qualifie de "vraiment gigantesque" (en bougeant les bras !).

Le premier gigabay sera construit au Texas, avec une installation supplémentaire prévue en Floride, dans le cadre des ambitions de SpaceX de lancer plusieurs fusées par jour pour atteindre et coloniser Mars. Tu ne t’imagines pas l'ampleur du truc ! On parle d'un hangar capable d'accueillir mille fusées de la taille d'un immeuble de 40 étages. C'est comme si Musk voulait construire une cathédrale spatiale, mais en version XXL et avec des ambitions martiennes.

Alien Musk, CQFD !

L'ambition derrière ce projet dépasse largement le simple stockage.

Musk a expliqué que cette installation était nécessaire pour supporter la production de 1000 Starships par an, un rythme de fabrication qui transformerait littéralement l'industrie spatiale.